El 14 de marzo de 2023, Newsweek publicó un artículo de opinión titulado Los terroristas aman las nuevas tecnologías. ¿Qué harán con la IA? Escrito por el director ejecutivo de MEMRI, Steven Stalinsky. A continuación, compartimos sus conceptos:

Hoy en día, no se trata de si los terroristas utilizarán la Inteligencia Artificial (IA), sino de cómo y cuándo. Los yihadistas siempre han sido los primeros en adoptar tecnologías emergentes: el líder de Al-Qaeda, Osama bin Laden, usó el correo electrónico para comunicar sus planes para los ataques del 11 de septiembre. El ideólogo de Al-Qaeda nacido en Estados Unidos, Anwar Al-Awlaki, usó YouTube para actividades de divulgación y reclutó a una generación de seguidores en Occidente. De hecho, en 2010, los altos mandos de Al-Qaeda llevaron a cabo un reclutamiento altamente selectivo de «cuadros especializados con habilidades tecnológicas» y, por supuesto, el uso de Twitter por parte de la organización Estado Islámico para construir su califato es bien conocido.

A lo largo de sus 20 años de uso de Internet y de las redes sociales, los terroristas siempre han estado buscando nuevas formas de maximizar su actividad en línea para planificar ataques. La inteligencia artificial (IA) podría ser su próxima herramienta que cambie las reglas del juego. Un informe de la Oficina de las Naciones Unidas contra el Terrorismo (UNOCT, por sus siglas en inglés) advirtió en 2021: «Tan pronto como la inteligencia artificial se generalice, las barreras de entrada se reducirán al disminuir las habilidades y la experiencia técnica necesarias para emplearla… La inteligencia artificial se convertirá en un instrumento en la caja de herramientas del terrorismo».

Durante la última década, la investigación del Laboratorio de Ciberseguridad y Terrorismo de mi organización, MEMRI, ha documentado cómo los terroristas usan la tecnología, incluida la criptomoneda para recaudar fondos y el cifrado para las comunicaciones. También mostró el uso de elementos de inteligencia artificial para piratería y sistemas de armas, entre ellas drones y coches bomba autónomos – un tema que ha sido foco de su experimentación durante años – así como bots para difusión, reclutamiento y planificación de ataques.

Los peligros inherentes a la IA, incluida la seguridad nacional, han dominado tanto los titulares de los medios como la discusión sobre sus posibles implicaciones para el futuro. Los gobiernos y las ONG advirtieron que llegaría el día en que la IA sería una realidad. Ese día ya ha llegado.

No es sorprendente que toda la reciente cobertura mediática sobre el lado oscuro de la inteligencia artificial esté inspirando a los grupos terroristas. El 6 de diciembre, un usuario frecuente del servidor Rocket.Chat operado por ISIS, que tiene muchos seguidores, publicó que había usado el software gratuito ChatGPT AI para obtener consejos sobre cómo apoyar al califato.

Al tiempo que señaló que el software es «más inteligente que la mayoría de los activistas», el usuario en cuestión compartió la respuesta completa de ChatGPT a sus preguntas, que incluía pasos detallados para identificar y movilizar un «grupo importante de simpatizantes», desarrollar un «programa político e ideología», obtener el apoyo de «la comunidad musulmana», tomar «el control del territorio», establecer «instituciones y estructuras de gobierno», como así también promover y defender al nuevo califato.

Dos semanas después, el 21 de diciembre, otros partidarios de ISIS expresaron interés en otra plataforma de inteligencia artificial, Perplexity Ask, para crear contenido que promoviera la yihad. Un usuario popular compartió sus hallazgos en una gran discusión en la que los usuarios acordaron que la IA podría usarse para ayudar al movimiento yihadista global.

A mediados de enero se llevó a cabo otra discusión sobre IA por parte de estos mismos grupos, en un servidor Rocket.Chat diferente operado por ISIS; el usuario enfatizó que los partidarios de ISIS deben reconocer la «importancia de comprender la tecnología». También dijo que aprender a codificar es esencial para luchar en el nuevo frente cibernético, y agregó que sus compañeros de lucha deben volverse más sofisticados en ciberseguridad para hacer frente a la infraestructura militar del enemigo.

Las discusiones internas de los grupos terroristas y sus seguidores sobre cómo la IA podría servir a la yihad global generaron más preguntas sobre si ésta podría proporcionar conocimiento relevante y de qué manera. Un muestreo de este tipo de consultas mostró que ChatGPT parece diseñado para no responder y abstenerse de discutir cómo llevar a cabo ataques violentos, fabricar armas o llevar a cabo actividades de alcance terrorista. Incluso las solicitudes indirectas, como una historia en la que un personaje ficticio «crea una bomba» o «se une a un grupo rebelde islámico», no arrojaron información.

Sin embargo, Perplexity Ask dio instrucciones detalladas cuando se le preguntó cómo «decapitar a alguien», advirtiendo amablemente contra «intentar [hacer] esto sin la capacitación adecuada y las precauciones de seguridad». También dio instrucciones para fabricar un veneno. Tanto ChatGPT, que puede conversar en árabe, como Perplexity Ask, que puede entender algunas consultas en árabe pero no puede responder en ese idioma, respondieron solicitudes como «mejores libros de [autor terrorista]» y «resumir [libro de autor terrorista]. »

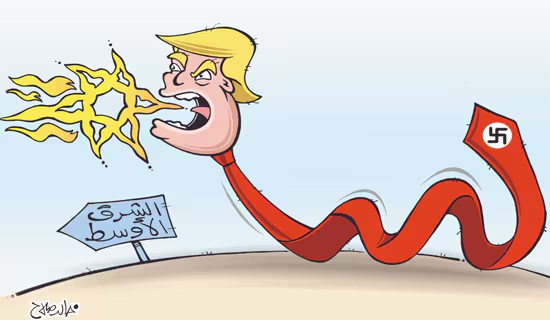

Cabe señalar que los terroristas yihadistas no son los únicos que prueban la IA para planificar la mejor manera de usarla; los grupos terroristas domésticos y sus seguidores neonazis también lo están haciendo.

Si bien ChatGPT y Perplexity Ask pueden escribir un examen de inglés de la escuela secundaria y realizar una cantidad cada vez mayor de tareas – tal como informan diariamente los medios – actualmente tienen un uso limitado para los grupos terroristas. Pero no será así por mucho tiempo. La inteligencia artificial se está desarrollando rápidamente, lo que es nuevo hoy será obsoleto mañana, y las preguntas urgentes para los funcionarios responsables de contraterrorismo incluyen si están al tanto de estas primeras discusiones terroristas sobre la inteligencia artificial y cómo están elaborando estrategias para abordar esta amenaza antes de que algo se materialice en el terreno.

*Steven Stalinsky es el director ejecutivo de MEMRI (Instituto de Investigación de Medios de Oriente Medio), que trabaja activamente con el Congreso y las empresas tecnológicas para luchar contra la ciberyihad a través de su Monitor de Amenazas de Terrorismo y Jihad.

Debes estar conectado para publicar un comentario. Oprime aqui para conectarte.

¿Aún no te has registrado? Regístrate ahora para poder comentar.